From 01563d427c4342dfe88dfb9bb9f23c9cf65db823 Mon Sep 17 00:00:00 2001

From: yangj1211 <153493538+yangj1211@users.noreply.github.com>

Date: Mon, 13 May 2024 14:07:59 +0800

Subject: [PATCH] add doc of architecture-matrixone-operator (#1065)

---

.../architecture-matrixone-operator.md | 153 ++++++++++++++++++

mkdocs.yml | 1 +

2 files changed, 154 insertions(+)

create mode 100644 docs/MatrixOne/Overview/architecture/architecture-matrixone-operator.md

diff --git a/docs/MatrixOne/Overview/architecture/architecture-matrixone-operator.md b/docs/MatrixOne/Overview/architecture/architecture-matrixone-operator.md

new file mode 100644

index 0000000000..e6b903c2b3

--- /dev/null

+++ b/docs/MatrixOne/Overview/architecture/architecture-matrixone-operator.md

@@ -0,0 +1,153 @@

+# Matrixone-Operator 设计与实现详解

+

+MatrixOne 是一款云原生分布式数据库,天然适应云基础设施并面向云的成本模型进行优化。而与一般的 SaaS 服务不同,出于对性能和数据安全的需求,在严肃场景下数据库往往需要跟着应用走,与应用运行在相同的基础设施上。为了服务尽可能多的用户,MatrixOne 需要适配各类公有云、私有云乃至混合云。而其中的最大公约数正是 Kubernetes(下文简称 K8S)。因此,MatrixOne 将 K8S 作为分布式部署时的默认运行环境,以统一方式适配不同的云。

+MatrixOne-Operator 正是 MatrixOne 在 K8S 上的自动化部署运维软件,它扩展 K8S,以 K8S 风格的声明式 API 对外提供 MatrixOne 集群的运维管理能力。

+

+这篇文章将解读 MatrixOne-Operator 的设计与实现,并分享我们的经验思考。

+

+## MatrixOne-Operator 设计

+

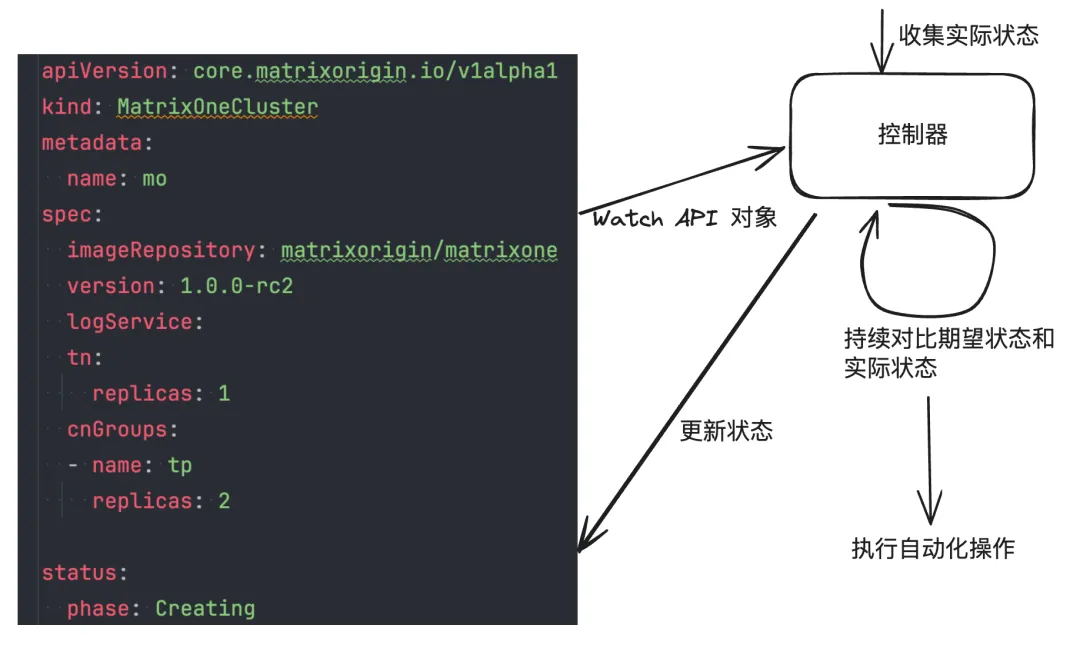

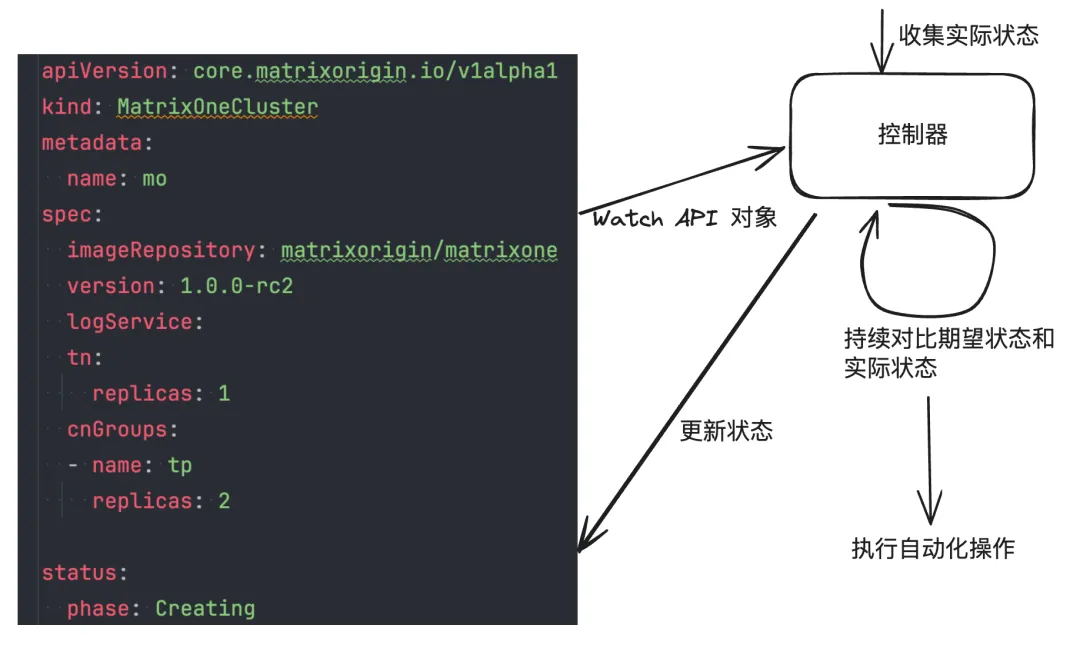

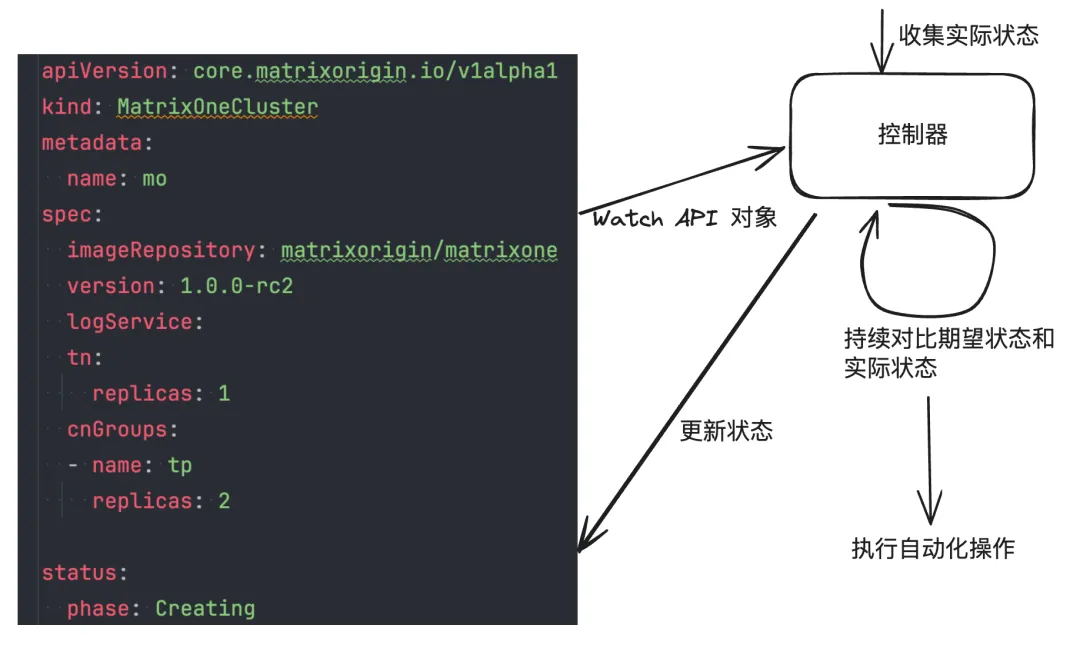

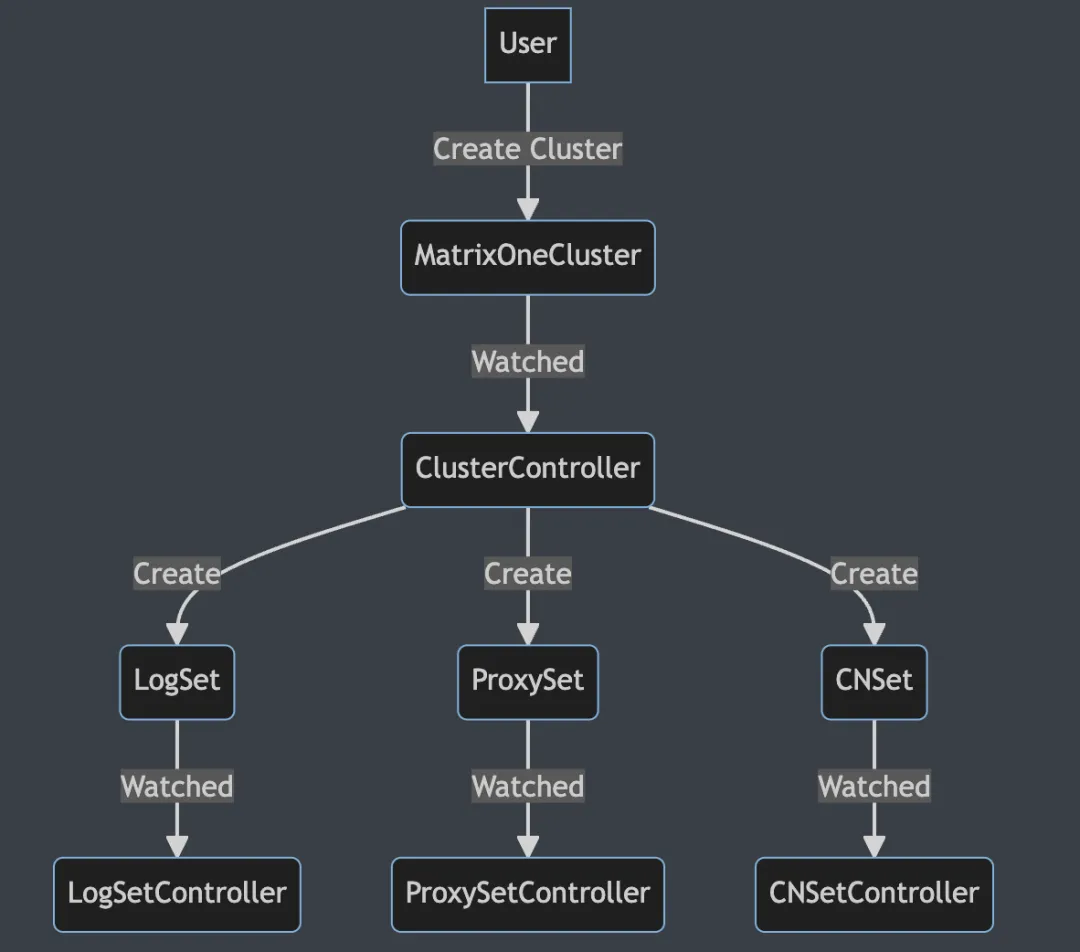

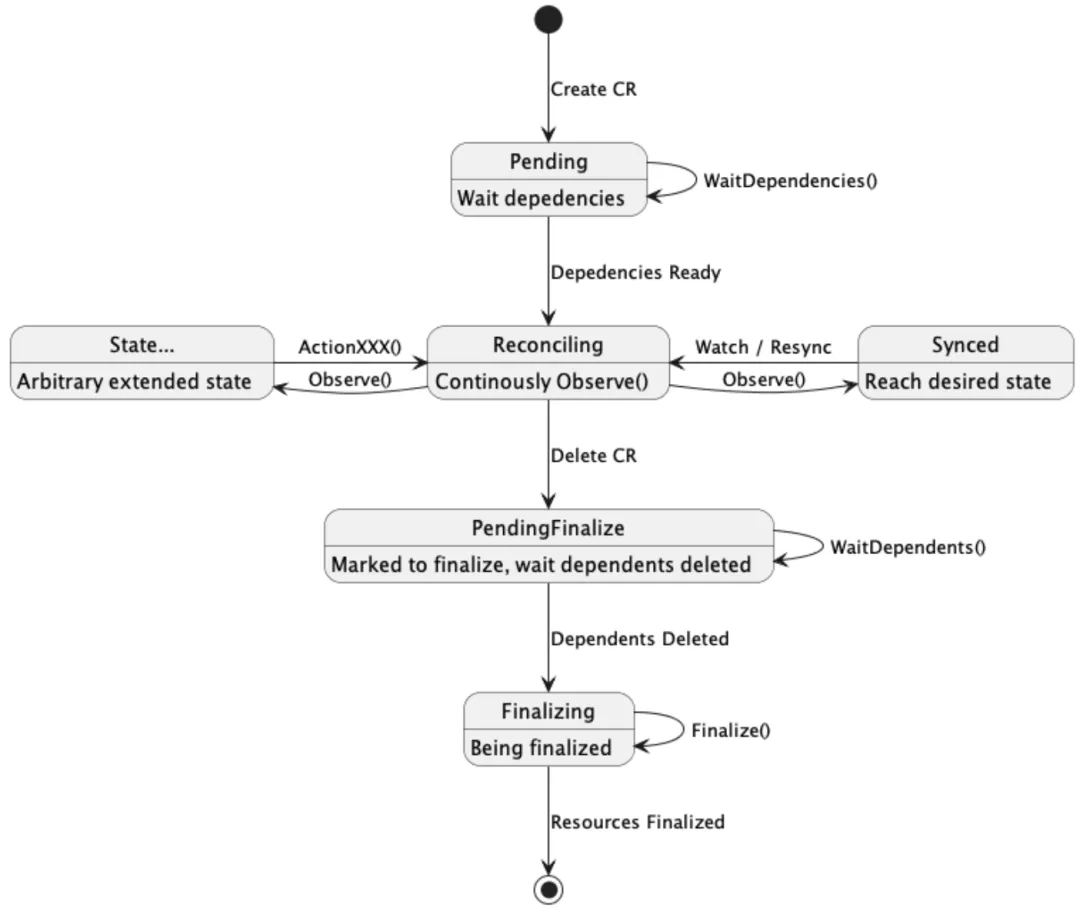

+尽管 K8S 原生提供了 StatefulSet API 来服务有状态应用的编排,但由于不同有状态应用的应用层状态难以进行统一抽象,因此 K8S 原生并不支持管理应用状态。为了解决这一问题,Operator 模式应运而生。一个典型的 K8S Operator 由 API 和控制器 (Controller) 两部分构成:

+

+- API

+

+通常通过 K8S 的 CustomResourceDefinition(CRD)对象进行声明,在提交一个 K8S CRD 到 K8S 的 api-server 后,api-server 就会在自身注册一个对应的 Restful API。所有的 K8SClient 都能以类似操作原生资源的方式对这个新声明的 API 进行 GET,LIST, POST, DELETE 等操作。按照惯例,每个 API 对象内的,`.spec` 结构由用户管理,用于声明对象的期望状态,`.status` 结构则由下文的控制器管理,用于对外暴露对象的实际状态。

+

+- 控制器

+

+控制器是一段持续运行的代码,它监视 (watch) 一系列 K8S 对象,包括我们刚刚定义的 API 对象。然后,根据这些对象的期望状态和从现实中收集到的实际状态(注意:这里的实际状态是从现实中收集到再写进 `.status` 的,而不是直接来自 `.status`)执行自动化操作,驱动实际状态向期望状态转移。这个过程会持续循环进行,被形象地称作“控制循环”(control loop),有些地方也会用一个更具古典乐风味的词“调谐循环”(reconciliation loop),巧妙地和 K8S 的“编排”(Orchestration) 一词保持了风味统一。

+

+下图以简化后的 MatrixOneCluster API 作为例子,概括性地描述了这个过程:

+

+

+

+

+

+

+

+

+

+

+

+

+

+ +

+ +

+ +

+ +

+ +

+